合成孔径雷达(Synthetic Aperture Radar, SAR)能够全天时、全天候、高分辨率成像,因此适用于目标的侦察、监视和识别,同时也已经被广泛应用于地球科学、气候变化研究、环境和地球系统监测、海洋资源利用、行星探测、战场感知侦察等领域,具有很高的民用价值和军用价值[1–3]。由于其微波波段成像和相位相干处理的特性,SAR图像与光学图像表现不同,难以直观解读。事实上,SAR图像包含了丰富的目标信息,例如几何形状、材质、结构等。SAR图像解译和信息获取是在轨雷达卫星实现成功应用的最后决定性的一步。

遥感大数据时代下的SAR图像解译是一个极大的科学应用挑战。大数据时代的智能方法如计算机视觉技术目前已经取得巨大成功,然而这些先进算法是针对光学图像开发的,并不能直接应用到SAR图像上。我们认为SAR图像解译和信息获取,必须基于对基本的电磁(Electro Magnetic, EM)散射机制的理解。因此SAR智能信息获取的发展必须同时在数学层面结合智能信息处理方法、在物理层面结合电磁散射理论。

目前我们迫切需要发展先进的SAR智能信息获取方法。每天都有海量的数据从太空返回而等待处理,需要强大的解译和信息获取方法。各种先进SAR技术的快速出现,使得SAR数据朝着更高分辨率、更高维度、更多成像模式的方向发展。高分辨率-多维度-多模式(HR-MD-MM)SAR数据的出现,使得基于2维框架结构的解译系统面临巨大挑战。

近年来,深度学习在模式识别的各个领域取得了较好的结果,比如,图像分类,目标检测,自然语言处理。常用的深度学习算法包括深度信念网络(Deep Belief Network, DBN),卷积神经网络(Convolutional Neural Network, CNN),循环神经网络(Recurrent Neural Network, RNN)等等。其中,CNN是在计算机视觉领域中最常采用的算法。传统的图像分类问题分为特征提取与特征分类两个阶段,其中特征提取是依据统计或者物理特性进行手动设计的算法。但是,这种模式现在完全被自动学习数据分层特征的CNN取代[4,5]。CNN在图像分类领域已经取得了一系列突破。在2012年ImageNet大规模视觉挑战赛(Imagenet Large Scale Visual Recognition Challenge, ILSVRC),Krizhevsky等人[4]采用深度卷积网络取得了15.3%的错误率,远远超过以往最好的水平。在2014年,Szegedy等人[6]提出了一个包含22层的GoogleNet,将前5项错误率降至6.67%。在2015年,He等人[5]提出152层的残差网络(Residual Network, ResNet)并取得了3.57%的整体错误率。2016年,中国公安三所团队在ILSVRC中取得第1名成绩,错误率已降至3%以下[7]。

相对于计算机视觉,SAR图像解译有着相同的目的——从图像中提取有用信息,但所处理的SAR图像与可见光图像有显著区别,主要体现在波段、成像原理、投影方向、视角等方面详见表1。因此在借鉴计算机视觉领域的新方法解决SAR图像解译的问题时,需要充分考虑和利用这些差异性。

| 表 1 SAR图像解译与计算机视觉的差异 Tab.1 Comparison of SAR imagery interpretation and computer vision |

针对当前对于深度神经网络的巨大兴趣,本文首先阐述了作者对于深度神经网络理论巨大成功背后主要原理的理解,然后归纳了作者将该理论应用于SAR图像解译方面的几项工作,包括SAR图像目标识别与极化SAR地物分类的应用。第2节介绍了CNN基本算法以及复数域推广后的CV-CNN;第3节介绍CNN在目标识别中的应用;第4节介绍CV-CNN在极化SAR地物分类中的应用。

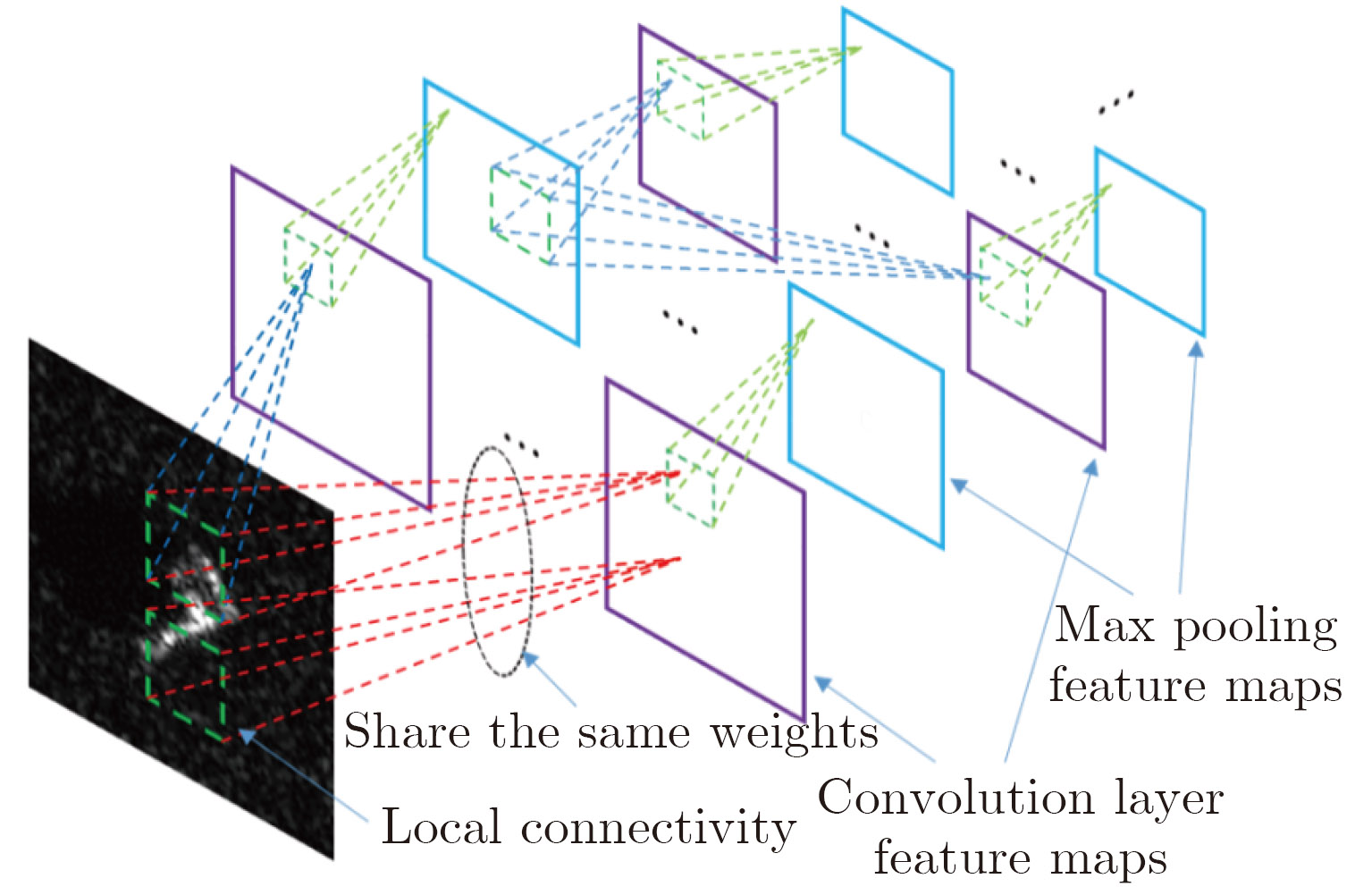

2 深度卷积神经网络及其复数域的推广 2.1 深度卷积网络深度卷积网络(Convolutional Neural Network, CNN)是一种特殊结构的深度神经网络,其前几层由卷积层(Convolution layer)与池化层(Pooling layer)交替构成,后面若干层是全连接层。其工作原理是由卷积层学习不同的特征,由池化层将空域形状汇聚到高维特征空间,多层交替的卷积+池化可以学出层次化的特征表征。最后的全连接层的作用则是在高维特征空间学习一个分类器。

如图1所示,CNN中卷积层和池化层的所有节点都排列成一系列2维数组,叫做“特征图”(Feature map)。在卷积层中,每个隐层节点的输入仅包含前一层中1个局部邻域内的节点。前一层处于局部邻域内的节点乘以1个权值矩阵,再通过1个非线性激活函数“正则化线性单元”ReLU[8],运算结果作为卷积层的节点输出值。每个隐层节点都可以被看作是一个特征检测器,因为当其输入中出现它所代表的某种特征时,该节点便有一个较大的响应值。同一个特征图上的全部节点被限制为共享相同的连接权值,所以每个特征图在图像的不同位置检测同一种特征。由于局部连接和权值共享,CNN中需要从数据中学习的独立参数的个数大为减少。在接下来的池化层中,每一个池化层特征图对应于1个卷积层特征图。池化层的每个节点以前面卷积层中1个局部邻域内的节点为输入,然后进行下采样。通常的方法是只保留1个局部邻域内所有节点的最大值,而忽略其余的节点值。1个深度卷积网络包含许多对卷积层与池化层的组合。当处理多元分类问题时,softmax非线性函数通常应用于最后的输出层节点。

CNN在业界所取得的巨大成功得益于:(a)算法的改进;(b)海量数据的获得;(c)图形处理单元(GPU)等高性能计算资源的普及,而其中算法的改进是深度神经网络出现飞跃式发展的关键因素。对比80年代的传统神经网络,我们认为深度神经网络特别是CNN在算法上的重要改进可以归纳为以下几点:

(1) 改进的网络结构

传统神经网络层与层之间采用全连接形式,即前一层的每个神经元都与后一层的所有神经元相连,CNN则采用了改进的网络结构,采用卷积形式前后相连,且添加了池化操作进行降维。其中卷积形式的连接充分借鉴了视觉神经信号处理的特点,即平移不变性。而多层卷积+池化的结构则借鉴了视觉神经信号处理的另一个重要特点,即多层次特征可组合性(见图2)。这一独特的网络结构可以有效地从海量数据中学到层次化组合的特征,对视觉信息进行高效地表征。从这一点我们得到的启发是:应有效利用先验知识来降低网络自由度。

|

图 2 层次化可组合的特性表征能力 Fig.2 Hierarchical compositional feature representation capability |

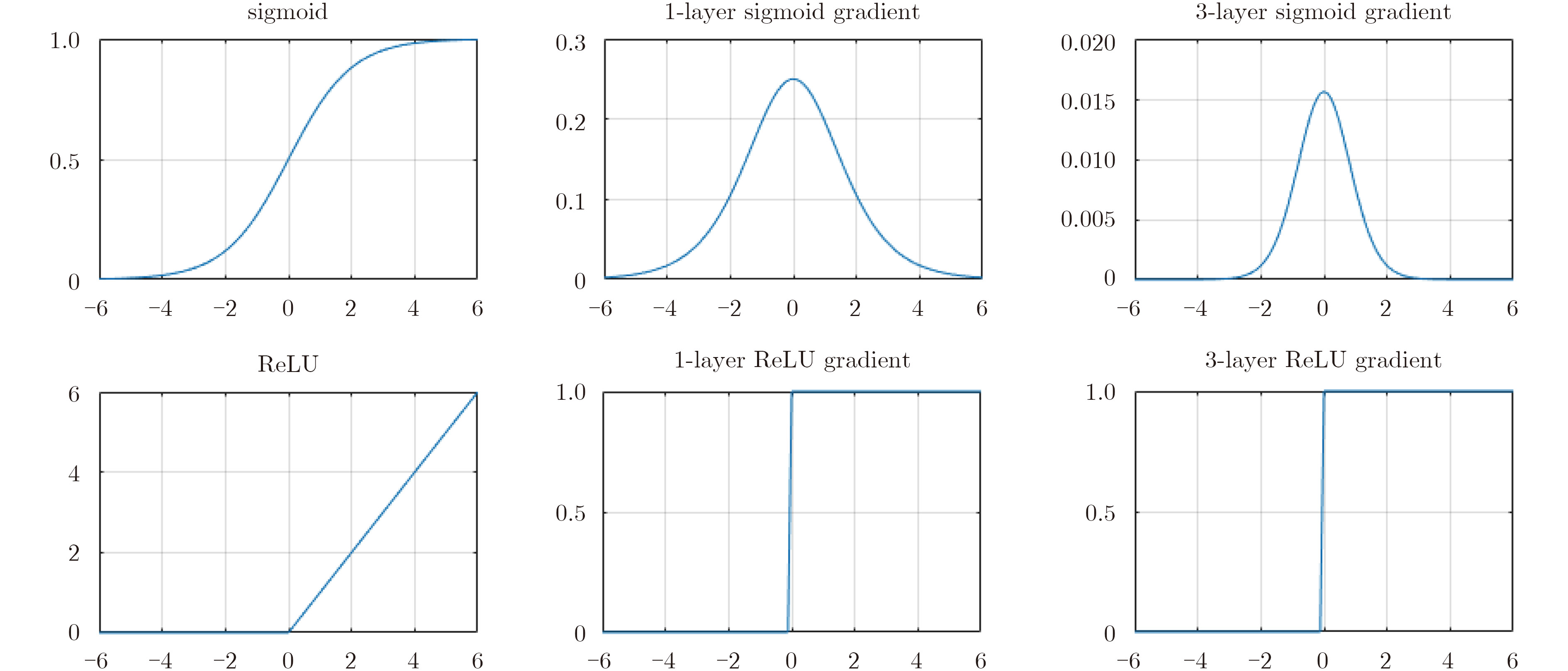

(2) 改进的激活函数

在80年代即有人尝试加深网络深度,但深度神经网络的学习是一大难题。当代深度神经网络的另一个重要改进就是采用ReLU激活函数。神经网络学习时后向传播误差信息,其梯度随着网络深度的增加很容易出现不稳定的现象,特别是传统非线性激活函数如sigmoid或tanh函数,其梯度在原点呈现一个尖峰,在离开原点不远处立即饱和。多层网络回传时梯度被累乘,导致多个sigmoid/tanh函数的梯度累乘后在原点处爆炸、在离开原点处消失。如此非常不稳定的梯度将使得梯度下降的学习方法失效,从而限制了神经网络的层数增加,因此也大大限制了神经网络的表征能力。如图3所示,改进的激活函数ReLU的梯度在右侧恒等于1,其梯度在累乘后保持稳定,这是深度网络能够快速学习的重要原因。

|

图 3 两种激活函数及其梯度比较 Fig.3 Two types of activation function and their gradients |

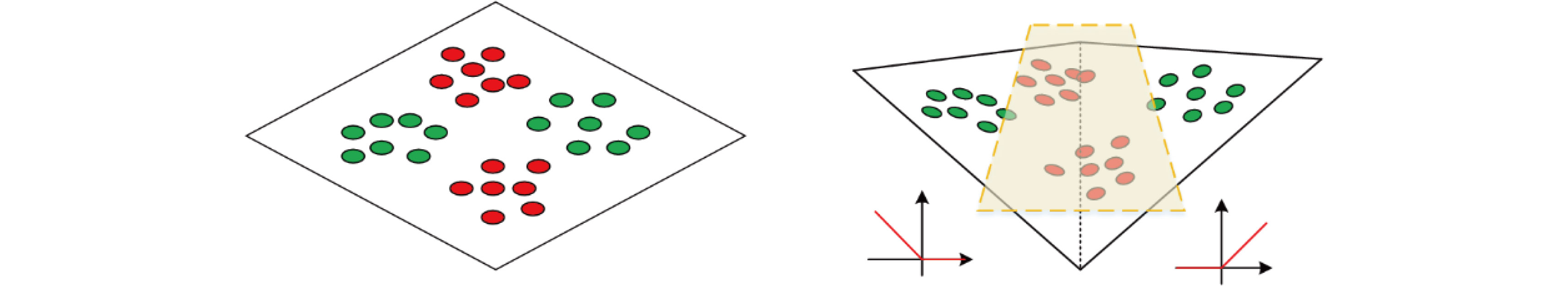

ReLU在x正半轴为线性,而负半轴则相当于关闭神经元。这一看似简单的非线性对于神经网络表达能力的扩展至关重要。多层线性感知机(Multi Layer Perceptron, MLP)的一个重要缺陷就是无法解决异或(XOR)分类问题,即通过无限多神经元的线性组合均无法实现图4左侧的两类样本的分类,而如图4右侧所示,通过两个ReLU神经元的组合即可轻易解决这一问题。由此可见ReLU中所呈现的非线性是必要的。

|

图 4 通过ReLU的非线性解决XOR问题 Fig.4 XOR problem solved by using the nonlinearity of ReLU |

(3) 改进的目标函数

对于分类应用,还采用了改进的目标函数,即首先在输出层采用Softmax结构,使得最终输出为归一化的概率。其次通过输出概率与标签概率的交叉熵作为目标函数进行学习。Softmax采用了指数函数,与交叉熵结合,最终目标函数对于输出层神经元参数的梯度变为线性函数,有效避免了梯度回传时的非线性失真。如式(1)所示,Oi

为输出层的第i个神经元的输出信号,pi

为Softmax归一化的概率输出,L为交叉熵目标函数,y为标签指定的正确类别的下标,

| $\left. {\begin{array}{*{20}{c}}{{p_i} = \frac{{\exp \left( {O_i^{\left( L \right)}} \right)}}{{\displaystyle\sum\limits_{j = 1}^K {\exp \left( {O_j^{\left( L \right)}} \right)} }},\;i = 1, ·\!·\!· ,K}\\{L = \sum\limits_{j = 1}^K { - \delta \left( {y - j} \right)\log {p_i} = - \log {p_y}} }\\\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\! {\frac{{\partial L}}{{\partial {O_j}}} = \delta \left( {y - j} \right) - {p_j}}\end{array}} \right\}$ | (1) |

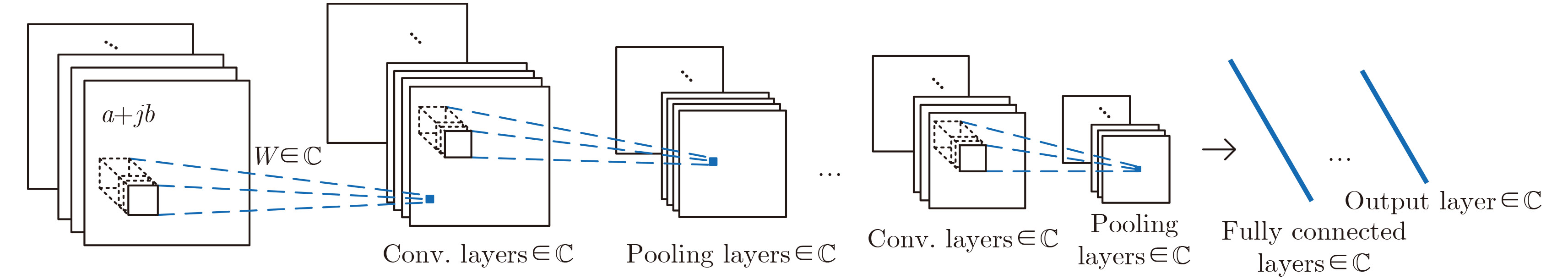

根据我们的经验,一般的CNN即可直接应用于SAR幅度图像,仅需对SAR幅度图像做简单的预处理,如转换为dB尺度,并进行归一化等。后文中第1个例子处理的单通道幅值SAR图像即采用一般的实数域CNN。但对于多通道相干的SAR图像,如极化SAR或干涉SAR,其通道间相干相位差带有重要信息。因此针对带相位信息的SAR图像我们将CNN推广到了复数域,称为复数卷积网络(Complex-Valued-CNN, CV-CNN)[10]。为了区分,实数神经网络可称为Real-Valued CNN (RV-CNN)。特别是如极化SAR和干涉SAR,均包含了不同通道之间的相位差,该相位信息不再是完全随机的,往往隐含了散射地物的表1位置、形状、散射机制的信息,这些信息对地物分类和识别至关重要。

值得说明的是传统的浅层复数神经网络包括浅层复数卷积网络也曾被应用于极化SAR图像处理[11],但之前的研究采用的是传统的仅包含1个隐层的网络,而正如上一节所说深度神经网络的巨大成功在于它特有的几个变革性的特性,因此我们提出的CV-CNN是将最新的深度神经网络及其关键的几个特征均推广到复数域的情况。

CV-CNN不仅将复数数据作为输入,同时对各层传递了相位信息,也即每一层的神经元信息和权重均由复数表示,这意味着所有的神经元操作以及学习算法都需要推广至复数域。

如图5所示,CV-CNN卷积层将输入数据与可学习的滤波器进行卷积,输入输出均可为2维矩阵。卷积结果经过非线性激励函数生成特征图。非线性激励函数常用的有sigmoid, ReLU[8]等。卷积层的下一层通常为池化层,用于下采样特征图,从而减少网络参数。卷积神经网络的特性包括局部连接、权值共享、池化以及串联多层[12]。对于CV-CNN,网络的所有参数包括卷积层、池化层特征图以及滤波器均为复数。关于CV-CNN的详细推导参见文献[10]。

3 深度卷积神经网络应用于目标识别 3.1 网络结构针对SAR图像数据比较少、对观测条件敏感等特点,直接用SAR数据来训练CNN很容易出现过拟合(Overfitting)的问题。因为CNN自由参数太多,但训练样本不充足,这就导致了严重的过拟合。值得注意的是,CNN中绝大部分的可训练参数都包含在全连接层。一些实验结果表明,网络的层数对于CNN的性能具有最重要的影响[13]。因此,我们通过用卷积层取代全连接层,而不是大量地减少网络的层数,来减少需要训练的参数。尽管这种改变降低了网络的表示能力,但是也大大减小了过拟合。

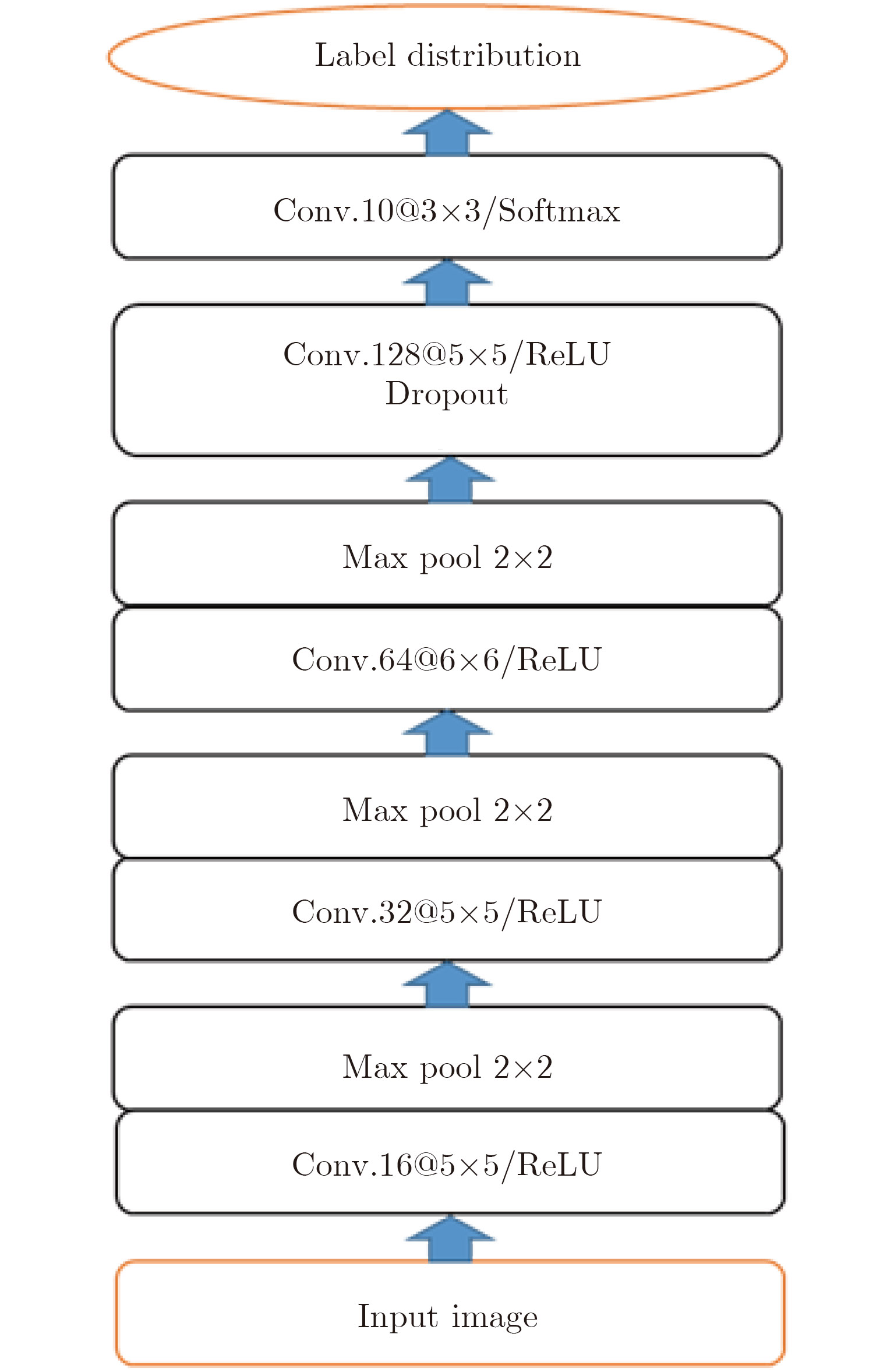

我们提出的CNN包含5个可训练层[9],如图6所示,总共包含5个卷积层和3个池化层。前3个卷积层的后面接有池化层,采用max pooling形式,下采样窗口的大小(Pooling size)取2×2,滑动步长(stride)取2。ReLU非线性激活函数作用于前4个卷积层。Softmax非线性函数作用于第5个卷积层的输出节点。卷积层中卷积核的滑动步长(stride)全部取2,输入特征图的周围没有补零。输入图像的大小为88×88,第1个卷积层选取了16个大小为5×5的卷积核,输出为16个大小为84×84的特征图。经过第1个池化层后特征图的大小变为42×42。第1个池化层的输出送入第2个卷积层,它包含32个大小为5×5的卷积核,生成32个大小为38×38的特征图。经过第2个下采样层,特征图的大小变成19×19。第3个卷积层包含64个大小为6×6的卷积核,生成64个大小为14×14的特征图。经过第3个池化层后,特征图的大小变成7×7。第4个卷积层包含128个大小为5×5的卷积核,生成128个大小为3×3的特征图。Dropout[14]正则化方法也应用于第4个卷积层。第5个卷积层包含10个大小为3×3的卷积核,以保证有10个大小为1×1的输出节点,每个节点的输出值经过Softmax归一后对应于一个类别的概率。

|

图 6 网络整体结构,包含5个可训练层。卷积层表示为“conv.(卷积核数量)@(卷积核大小)” Fig.6 Network architecture, including 5 trainable layers. Convolution layer is denoted as “conv.(kernel depth)@(kernel size)” |

本文采用的实验数据是由Sandia国家实验室(SNL)的SAR传感器采集的。数据的采集是由美国国防部先进研究项目局(Defense Advanced Research Projects Agency, DARPA)和空军研究实验室(Air Force Research Laboratory, AFRL)共同资助的,作为运动和静止目标获取与识别(Moving and Stationary Target Acquisition and Recognition, MSTAR)项目的一部分[15]。该项目采集了几十万张包含地面军事目标的SAR图像,其中包括不同的目标类型、方位角、俯仰角、炮筒转向、外型配置变化和型号变种的目标SAR图像。公开的SAR数据集中包含10类不同的地面军事车辆(装甲车:BMP-2, BRDM-2, BTR-60, BTR-70;坦克:T-62, T-72;火箭发射车:2S1;防空单元:ZSU-234;军用卡车:ZIL-131;推土机:D7),由X波段SAR传感器采集,采用聚束式成像模式,方位向和距离向分辨率都是0.3 m,全方位角覆盖0°~360°。MSTAR基准数据集广泛运用于SAR-ATR算法的测试与比较。图7展示了10类目标的光学图像和同一方位角下的SAR图像。为了完整地衡量算法的性能,该算法同时在标准操作条件(Standard Operating Conditions, SOC)和扩展操作条件(Extended Operating Conditions, EOC)下进行测试。标准操作条件指的是测试SAR图像与训练SAR图像中目标的外形配置与型号相同,仅成像的俯仰角和方位角不同。扩展操作条件指的是测试SAR图像中的目标与训练SAR图像有很大的不同,主要是成像角度有很大的改变、外形配置的变化、训练集与测试集中同一类目标的型号不同。

|

图 7 10类军事目标示例:光学图像 vs. SAR图像 Fig.7 Ten-class military targets: optical image vs. SAR image |

在标准操作条件下,我们测试算法对于10类目标分类的结果。训练集和测试集中的同一类目标(Targetclass)具有相同的型号(Serialnumber),但是成像俯仰角与方位角不同。参照现有关于MSTAR目标识别的文献[9]中的普遍做法,训练SAR图像是17°俯仰角下采集的,而测试SAR图像是15°俯仰角下采集的,俯仰角相差2°被认为差异可以忽略。原始数据集中每一类目标的样本数不相等。人工提高训练样本数量(Data augmentation)是提高机器学习算法性能的一种常用技巧。我们在原始128×128大小的SAR图像切片中随机采样许多88×88大小的切片,因为在原始的SAR图像中,目标正好位于图像切片的中心,如图7所示,所以这就保证了每一张随机采样的图像切片都能够完整地包含目标区域。经过这种随机采样,每一类目标的训练样本数量最大提高(128–88+1)×(128–88+1)=1681倍。比如BMP-2装甲车,原来有233张训练样本,经过随机采样最大有233×1681张不同的样本。在本文中,每一类目标我们最终选择2700张训练样本。我们在人工扩展的数据集上训练模型。对于SAR图像我们没有做任何预处理。在标准操作条件(SOC)下的混淆矩阵如表2所示,混淆矩阵的每一行代表实际的目标类型,每一列代表模型预测的类型。

此外,我们还利用扩展操作条件(EOC)的两组数据集对所设计的CNN的泛化能力进行了测试,即测试数据与训练数据有不同特性,比如观测条件不同或目标配置有细微变化,结果表明该网络结构具有一定的泛化能力,详见文献[9]。该模型的参数配置和训练好的模型数据在作者主页上可公开获得。

| 表 2 SOC实验条件下的混淆矩阵 Tab.2 Confusion matrix under SOC setting |

地物分类是极化SAR应用的一个重要领域。传统的POLSAR图像分类的算法通常可分为3类:其一基于散射矩阵的统计特性[16,17],另外一种方法是基于内在的极化散射机制特性[18,19],第3种方法结合了极化散射特性以及统计特性[20,21]。我们将卷积神经网络应用于极化SAR数据分类[22],并用实测数据进行验证,实验结果取得了较高的分类正确率。

4.1 实数网络模型根据互易原理,单站全极化SAR数据可以用3×3相干矩阵 T 表示,这里除对角线元素外,其它元素均为复数。但深度卷积网络的输入都为实数,在考虑相干矩阵各元素的基础上,我们将复数 T 矩阵转化为1个6维的实向量。

| $\left. {\begin{array}{*{20}{l}}{A = 10{{\lg }}\left( {{\rm{SPAN}}} \right)}\\{B = {T_{22}}/{\rm{SPAN}}}\\{C = {T_{33}}/{\rm{SPAN}}}\\{D = \left| {{T_{12}}} \right|/\sqrt {{T_{11}} \cdot {T_{22}}} }\\{E = \left| {{T_{13}}} \right|/\sqrt {{T_{11}} \cdot {T_{33}}} }\\{F = \left| {{T_{23}}} \right|/\sqrt {{T_{33}} \cdot {T_{22}}} }\end{array}} \right\}$ | (2) |

这里,A为总功率取dB,其中SPAN=T11+T22+T33;B和C分别为归一化的T22和T33;D, E, F分别为相对相关系数。除A之外,其它5个参数取值范围都是在[0, 1]。

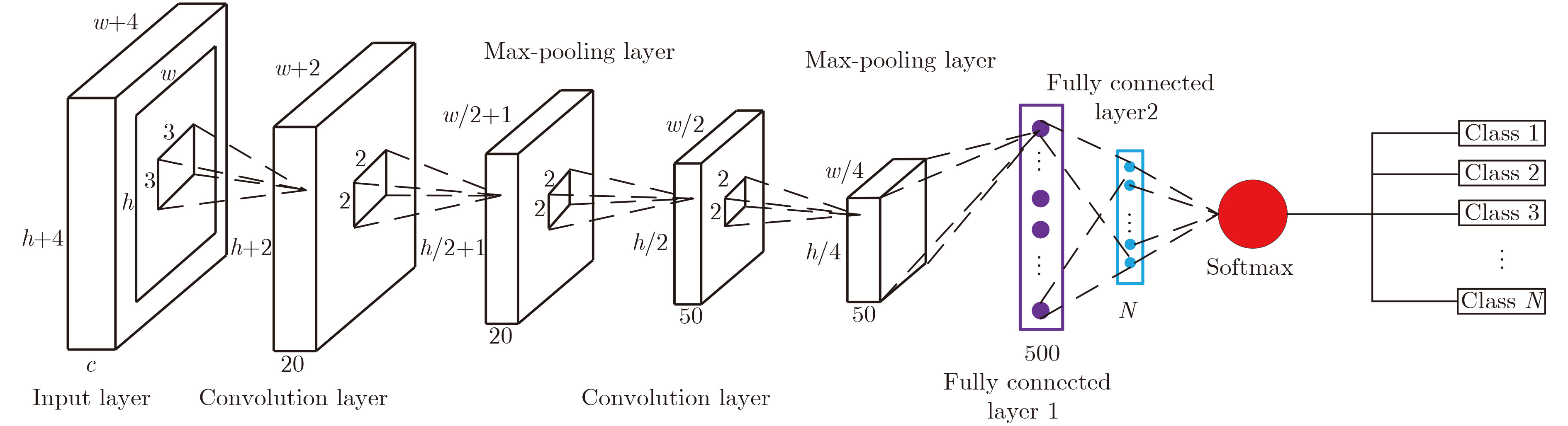

网络结构如图8所示,其中h, w, c分别表示输入层图像的行数、列数与通道数。通过补零操作,输入层大小变为(h+4)×(w+4)×c,这里h, w, c分别为8, 8, 6。

|

图 8 实数卷积神经网络结构 Fig.8 Real-valued convolutional neural network architecture |

实验数据采用AirSAR全极化L波段旧金山地区数据,如图9(a)所示。其中方框代表训练数据,圆圈代表测试数据。将地物分为5类,粉色代表高密度城区,绿色代表低密度城区,红色代表建筑物排列有一定角度区域,棕色为植被区,灰色为海洋。分类结果如图9(b)所示,将上述网络进行10000次循环,训练和测试的准确率分别达到99.43%和90.23%。

|

图 9 全极化L-波段旧金山地区AirSAR图像 Fig.9 Fully-polarimetric L-band AirSAR image of San Francisco area |

极化SAR多通道数据中,不同通道之间的相位差携带了重要信息。因此我们将测试推广到复数域的CV-CNN对于极化SAR地表分类的性能。在相同的网络结构以及参数设置条件下,用同样的数据测试CV-CNN的性能并与传统的实数神经网络进行比较,结果显示复数网络取得了较高的分类正确率。

图10展示了CV-CNN的网络结构。除了输入层与输出层,还包括2层卷积层,1层池化层以及1层全连接层。输入层的大小为12×12×6,表明采样窗口为12×12,通道数为6。因为卷积以及池化操作的降维作用,特征图的大小会随着层数的增加而减小。当输入数据尺寸小于12×12时,为了保证网络的特定深度,需要在输入数据的每一条边界进行补零操作。输入层与6个大小为3×3×6步长为1的卷积核进行卷积,与非线性激励后得到第1层卷积层,生成6个大小为10×10的特征图。接着是平均值池化,池化矩阵大小为2×2,步长为1。池化后特征图数量不变,大小变为5×5。第2层卷积的卷积核大小为3×3×6×12,生成12个大小为3×3的特征图。接着一层是包含108个神经元的全连接层,最后一层是包含c个神经元的输出层,输出数据也是复数,其中c为分类的类别数量。

|

图 10 CV-CNN的整体结构 Fig.10 Architecture of CV-CNN |

实验采用Flevoland地区全极化L波段的数据,是荷兰的一块农业区域。数据来源于美国NASA/JPL实验室发射的AIRSAR平台[23],是被广泛使用的用于POLSAR图像分类的一组数据。图11(a)是Pauli分解图,数据的大小为1024×750。图11(c)为Ground truth[24]。总共有15种类别,包括多种农作物、不同地表和建筑物等。图11(d)是Ground truth对应的图例。根据Ground truth,采用大小为8×8的滑动窗口进行采样。补零之后,输入数据的大小由8×8变成12×12。将随机采样的80%样本作为训练样本,剩下的作为测试样本。图11(b)是采样结果图,表3给出了训练样本以及测试样本的数量。

|

图 11 Flevoland数据 Fig.11 Flevoland data |

| 表 3 Flevoland数据分类结果 Tab.3 Flevoland result |

超参数设置为

|

图 12 分类结果 Fig.12 Classification result |

如图12(b)所示,分类结果与Ground truth相对一致,与图11(c)比较可以得到更直观的结果。大部分的像素分类正确,尤其是Forest, Lucerne and Barley。表3给出了实数网络与复数网络每一类的准确率。可以看出,大部分的类别分类正确率高于95%。除了Bare soil,所有的类别均高于90%。从原始的POLSAR图像可以看出,Bare soil与Water十分相似,误分的可能性较大。尽管第15类Building只有24个样本,分类正确率仍很理想。与RV-CNN相比,CV-CNN整体上的正确率更高,复数卷积网络对POLSAR分类是有效的。

值得注意的是,如果将复数数据直接拆分为实部/虚部(或幅度/相位)然后作为独立的实数通道输入到9通道RV-CNN中进行分类,该方法并不等同于CV-CNN,因为两个实数各自进行运算不等同于复数运算。我们的经验告诉我们9通道RV-CNN并不能提高分类性能。

4.3 地表分类网络的普适性为了进一步说明基于深度神经网络的极化SAR地表分类方法的实用性,我们进一步验证了利用已组数据训练的分类器对于其他类似数据的普适性。训练数据和测试区域来自不同时间不同区域获得的极化SAR图像,通过将预训练好的网络用于不同图像的分类,观察分类结果,以此评价学习方法的泛化能力。

训练数据来自南京地区的ALOS2极化SAR,获取时间为2016年4月14日,入射角为30.9°。图13为南京地区ALOS2图像,图中框出区域为用于训练的4类地物:建筑、植被、海洋和裸地。训练好分类器后对南京地区另外一区域和上海地区的ALOS2图像进行分类。

|

图 13 用于训练的南京某地区ALOS2图像 Fig.13 ALOS2 image of Nanjing used as training data |

图14显示的是南京另一区域的ALOS2极化SAR伪彩色图像、分类结果图和光学影像。对比光学影像,建筑、植被与水域等在两地分类都基本正确。由于测试区域裸露地表类别不是很明显,所以分类结果中黄色类别分布较分散零星。

|

图 14 用于测试的南京另一区域的结果 Fig.14 Results of another region in Nanjing used for testing |

图15显示的是上海某区域的ALOS2极化SAR伪彩色图像、分类结果和光学影像。获取时间为2015年3月9日,入射角为25.4°。虽然来自同一传感器,但其获取时间、地点、入射角均有很大差异,但从分类结果上看对于各种地物分类效果理想,说明极化SAR地表分类器对于同一卫星雷达的数据具有普适性。

|

图 15 用于测试的上海某区域的ALOS图像及其分类结果和对比光学影像 Fig.15 Results of Shanghai area used for testing |

本文介绍了将计算机视觉领域变革性新技术CNN应用于SAR图像解译的几个例子。文章尝试了深度卷积神经网络在SAR图像目标识别与全极化SAR地物分类中的应用。将CNN应用MSTAR数据,对于10类模板取得了平均99%的识别准确率。在地物分类中,分别考虑了实数和复数CNN网络。将实数网络应用于AirSAR旧金山区域数据,获得了90%以上的测试准确率。此外,为了利用SAR数据的相位信息,将实数CNN延伸至复数域CV-CNN。将CV-CNN在Flevoland数据集上进行分类实验,结果表明,在同等条件下CV-CNN相比RV-CNN有更高的分类正确率。

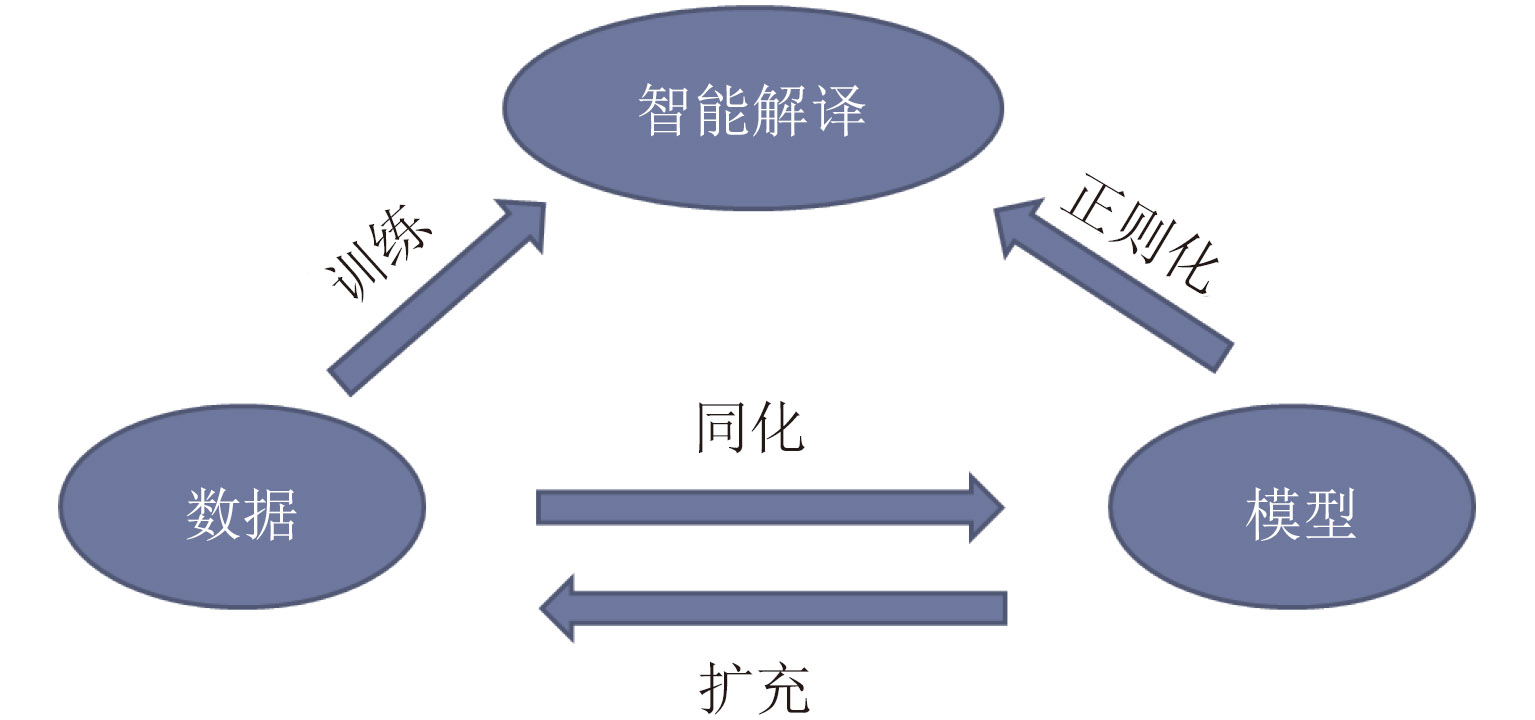

从本文的初步结果可见,利用深度学习技术可以在标准数据集上得到较理想的性能,但同时我们也认识到本文的例子所适用的范围有限,真正将深度学习技术应用到实际业务中还需要进行更深入更广泛的研究。如何利用深度学习技术进一步发展SAR图像智能解译是亟需研究的课题。图16给出一种数据驱动和模型约束下的SAR智能解译框架,深度学习技术本身必须由海量数据来驱动,但是往往人们忽视了模型的作用,也就是将先验知识融合到智能算法中。事实上,从深度卷积网络的巨大成功可以看出,其核心创新“多层卷积网络”结构即来源于对于视觉神经信号处理的理解。特别是针对SAR图像这样的电磁波散射物理过程的产物,我们需要融合电磁散射理论和机器学习理论,将物理规律等先验知识体现在智能解译算法中,这一目的可由模型与数据和算法三者协作达成:模型可以产生模拟数据,实测数据可以同化模型中,同时模型可以直接对机器学习算法进行正则化约束。

|

图 16 数据驱动-模型约束下的SAR智能解译 Fig.16 Data driven-model regularized intelligent SAR imagery interpretation |

| [1] |

张红, 王超, 张波, 等. 高分辨率SAR图像目标识别[M]. 北京: 科学出版社, 2009: 4–7.

Zhang Hong, Wang Chao, Zhang Bo, et al. High-Resolution SAR Image Target Recognition[M]. Beijing: Science Press, 2009: 4–7. (  0) 0)

|

| [2] |

Moreira A, Prats-Iraola P, and Younis M, et al. A Tutorial on Synthetic Aperture Radar[J].

IEEE Geoscience& Remote Sensing Magazine, 2013, 1(1): 6-43. ( 0) 0)

|

| [3] |

程肖. 基于散射中心模型的SAR图像自动目标识别[D]. [硕士论文], 国防科学技术大学, 2009.

Cheng Xiao. SAR ATR algorithm based on the scattering center model[D]. [Master dissertation], National University of Defense Technology, 2009. (  0) 0)

|

| [4] |

Krizhevsky A, Sutskever I and and Hinton G E. ImageNet classification with deep convolutional neural networks[J].

Advances in Neural Information Processing Systems, 2012, 25(2): 1097-1105. ( 0) 0)

|

| [5] |

He K, Zhang X, Ren S, et al. Delving deep into rectifiers: Surpassing human-level performance on ImageNet classification[C]. IEEE International Conference on Computer Vision, Santiago, Chile, 2015: 1026–1034.

( 0) 0)

|

| [6] |

Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]. IEEE Conference on Computer Vision and Pattern Recognition, Boston, M. A., USA, 2015: 1–9.

( 0) 0)

|

| [7] |

Large Scale Visual Recognition Challenge 2016 (ILSVRC2016). http://image-net.org/challenges/ LSVRC/2016/results.

( 0) 0)

|

| [8] |

Glorot X, Bordes A, and Bengio Y. Deep sparse rectifier networks[C]. International Conference on Artificial Intelligence and Statistics, Fort Lauderdale, United States, 2011: 315–323.

( 0) 0)

|

| [9] |

Chen S, Wang H, Xu F, et al. Target classification using the deep convolutional networks for SAR images[J].

IEEE Transactions on Geoscience & Remote Sensing, 2016, 54(8): 4806-4817. ( 0) 0)

|

| [10] |

Zhang Z, Wang H, Xu F, et al. Complex-valued convolutional neural network and its application in polarimetric SAR image classification[J].IEEE Transactions on Geoscience &Remote Sensing, in press.

( 0) 0)

|

| [11] |

Hänsch R and Hellwich O. Complex-valued convolutional neural networks for object detection in PolSAR data[C]. European Conference on Synthetic Aperture Radar, Aachen, Germany, 2010: 1–4.

( 0) 0)

|

| [12] |

Lecun Y, Bengio Y and and Hinton G. Deep learning[J].

Nature, 2015, 521(7553): 436-444. DOI:10.1038/nature14539 ( 0) 0)

|

| [13] |

Zeiler M D and Fergus R. Visualization and understanding convolutional networks[C]. European Conference on Computer Vision, Zurich, Switzerland, 2014: 818–833.

( 0) 0)

|

| [14] |

Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J].

Journal of Machine Learning Research, 2014, 15(1): 1929-1958. ( 0) 0)

|

| [15] |

Keydel E R. MSTAR extended operating conditions: A tutorial[C]. Algorithms for Synthetic Aperture Radar Imagery Ⅲ, Orlando, F. L., USA, 1996: 228–242.

( 0) 0)

|

| [16] | Kong J A, Swartz A A, Yueh H A , et al. Identification of terrain cover using the optimumterrain classifier[J].

Journal of Electromagnetic Waves & Applications, 2012, 2(2): 171-194. ( 0) 0)

|

| [17] |

Lee J S and Grunes M R. Classification of multi-look polarimetric SAR data based on the complex Wishart distribution[J].

International Journal of Remote Sensing, 1994, 15(11): 2299-2311. DOI:10.1080/01431169408954244 ( 0) 0)

|

| [18] | Freeman A, Villasenor J, Klein J D, et al. On the use of multi-frequency and polarimetric radar backscatter features for classification of agricultural crops[J].

International Journal of Remote Sensing, 1994, 15(9): 1799-1812. DOI:10.1080/01431169408954210 ( 0) 0)

|

| [19] |

Kouskoulas Y, Ulaby F T and and Pierce L E. The Bayesian hierarchical classifier (BHC) and its application to short vegetation using multi-frequency polarimetric SAR[J].

IEEE Transactions on Geoscience & Remote Sensing, 2004, 42(2): 469-477. ( 0) 0)

|

| [20] |

Lee J S, Grunes M R, Ainsworth T L, et al. Unsupervised classification using polarimetric decomposition and the complex Wishart classifier[J].

IEEE Transactions on Geoscience & Remote Sensing, 1999, 37(5): 2249-2258. ( 0) 0)

|

| [21] |

Cloude S R and Pottier E. An entropy based classification scheme for land applications of polarimetric SAR[J].

IEEE Transactions on Geoscience & Remote Sensing, 1997, 35(1): 68-78. ( 0) 0)

|

| [22] |

Zhou Y, Wang H, Xu F, et al. Polarimetric SAR Image Classification Using Deep Convolutional Neural Networks[J].

IEEE Geoscience and Remote Sensing Letters, 2016, 13(12): 1935-1939. DOI:10.1109/LGRS.2016.2618840 ( 0) 0)

|

| [23] |

Spaceborne and Airborne POLSAR Images[OL]. Available: http://envisat.esa.int/POLSARpro/datasets.html29.

( 0) 0)

|

| [24] |

Yu P, Qin A K and and Clausi D A. Unsupervised polarimetric SAR image segmentation using region growing with edge penalty[J].

IEEE Transactions on Geoscience & Remote Sensing, 2012, 50(4): 1302-1317. ( 0) 0)

|